<style>

.reveal {

font-size: 24px;

}

</style>

# Nefeli Cluster training

Π. Κορόσογλου, Αλ. Χαραλαμπίδου, Β. Αστερίου

**Μονάδα Ψηφιακής Διακυβέρνησης**

*10 Φεβρουαρίου 2026*

---

- Διάρκεια παρουσίασης: ~45 λεπτά

- Recording in progress...

- Διαφάνειες: https://notes.it.auth.gr/p/nefeli-intro#/

- Ερωτήσεις και απαντήσεις: https://notes.it.auth.gr/nefeli-intro-1-questions?both

---

## Γενικά περί High Performance Computing (HPC)

- Επίλυση μεγάλων προβλημάτων με απαιτήσεις που ξεπερνούν τις δυνατότητες συμβατικών υπολογιστών

- Συστοιχία HPC -> συντονισμένη ομάδα εκατοντάδων ή χιλιάδων CPUs που εργάζονται ταυτόχρονα

- Τοπική HPC υποδομή στο ΑΠΘ: Αριστοτέλης

---

## Auth Cloud Labs

<!--Μέσω του προγράμματος AUTHCloudLabs της ΕΔΥΤΕ και σε συνεργασία με τον ΕΛΚΕ ΑΠΘ και την Αντιπεριφέρεια Ψηφιακής Διακυβέρνησης της Περιφέρειας Κεντρικής Μακεδονίας, η Μονάδα Ψηφιακής Διακυβέρνησης του ΑΠΘ έχει αποκτήσει πρόσβαση σε πόρους στο Google Cloud Platform (GCP) για την δημιουργία ενός προσωρινού Computing Cluster.

Κατά συνέπεια, για ένα σύντομο χρονικό διάστημα, θα υπάρχει η δυνατότητα επέκτασης των υπολογιστικών πόρων που παρέχονται από την Μονάδα Ψηφιακής Διακυβέρνησης μέσω του Aristotle HPC cluster και με πόρους από το Google Cloud.-->

- Budget allocated: 612.076,00€

- Period: Sep 18, 2025 - May 20, 2026

*Το μεγαλύτερο μέρος του budget έχει αξιοποιηθεί για τη διαμόρφωση του Nefeli Cluster.*

---

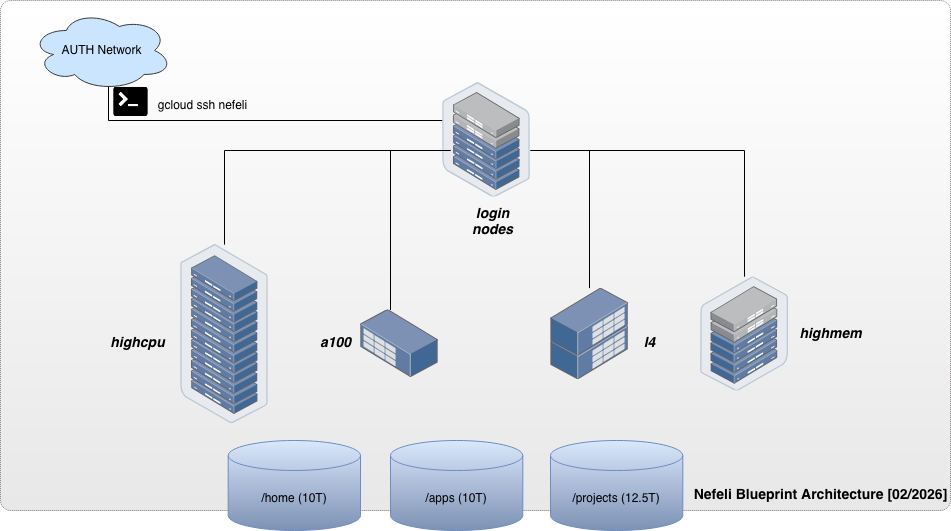

## Nefeli overview

---

## Nefeli partitions

| Partition | nodes | CPUs | Μνήμη ανά κόμβο[GB] | GPUs |

| --------- | ----- | ---- | ------------------- | --------- |

| a100 | 1 | 96 | 1360 | 16 x A100 |

| l4 | 1 | 24 | 96 | 2 x L4 |

| highcpu | 10 | 56 | 224 | - |

| highmem | 4 | 56 | 896 | - |

---

## Aristotelis vs Nefeli

| | Aristotelis | Nefeli |

| ---------------------- | ------------- | ------------- |

| CPU count | 2K+ (@2.0GHz) | 784 (@2.2GHz) |

| A100[40GB] GPU count | 8 | 16 |

| Other types of GPUs | 2x P100[12GB] | 2x L4[24GB] |

---

## Σύντομο poll

---

## Ενεργοποίηση HPC υπηρεσίας

Οδηγίες για την ενεργοποίηση της πρόσβασης: https://hpc.it.auth.gr/account/

→ Σύνδεση στο https://myaccount.auth.gr (απαιτείται [έλεγχος δύο παραγόντων – 2FA](https://it.auth.gr/faq/otp-idm-auth/))

---

## Σύνδεση στο Nefeli Google Cloud Cluster

Η σύνδεση γίνεται μέσω του [Google Cloud Command Line Interface](https://cloud.google.com/cli?hl=en) (`gcloud CLI`)

* Από τον υπολογιστή μας

* [σύνδεση στο VPN του ΑΠΘ](https://it.auth.gr/service/vpn/)

* [εγκατάσταση του gcloud CLI](https://hpc.it.auth.gr/nefeli-access/#_1)

* Από το login node του Αριστοτέλη

* [σύνδεση στο VPN του ΑΠΘ](https://it.auth.gr/service/vpn/)

* [gcloud commands](https://hpc.it.auth.gr/nefeli-access/#login-node)

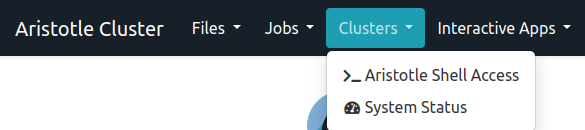

* Από το Web Portal του Αριστοτέλη: https://hpc.auth.gr

* **Clusters** → **Aristotle Shell Access**

* [gcloud commands](https://hpc.it.auth.gr/nefeli-access/#login-node)

---

## Σύνδεση για πρώτη φορά

* Οδηγίες πρόσβασης: https://hpc.it.auth.gr/nefeli-access

```

$ gcloud auth login --login-config=/mnt/apps/nefeli/login.conf --no-launch-browser

$ gcloud config set project cloudlabs-auth-20250918

$ gcloud config set compute/zone europe-west4-a

```

---

## Σύνδεση με gcloud από το web portal

* HPC web portal: https://hpc.auth.gr

```

$ gcloud auth login --login-config=/mnt/apps/nefeli/login.conf --no-launch-browser

$ gcloud beta compute ssh nefeli-slurm-login-001

```

---

## Μεταφορά δεδομένων

```

$ gcloud beta compute scp --recurse <directory-name> \

nefeli-slurm-login-001:/home/<username>

```

---

## Εντολές για την δρομολόγηση εργασιών

```

sbatch submit.sh # submit a job to the cluster

squeue -u username # check the status of submitted jobs

scancel jobid # cancel a submitted job

seff jobid # show resources of a finished job

```

---

## Υποβολή batch εργασιών σε HPC υποδομή

Κάθε εργασία θα πρέπει να περιέχει μία λίστα με "οδηγίες" (directives) προς τον scheduler σχετικά με τις εκτιμώμενες απαιτήσεις σε πόρους που θα πρέπει να δεσμευθούν, όπως:

- εκτιμώμενος χρόνος εκτέλεσης ( *time=01:00:00* )

- ομάδα μηχανημάτων ( *partition=highcpu* )

- πλήθος των απαιτούμενων nodes ( *nodes=2* )

- πλήθος επεξεργαστών (CPU Cores) ανά node ( *ntasks=4* )

- πλήθος των GPUs ( *gpus=2* )

> SBATCH directives: https://hpc.it.auth.gr/jobs/slurm/

---

## Υποβολή σειριακής εργασίας

```

#!/bin/bash

#SBATCH --job-name=serial-job-nefeli

#SBATCH --time=00:05:00

#SBATCH --partition=highcpu

#SBATCH --ntasks=1

echo "Job started on $(hostname)"

sleep 60

echo "Job finished after 60 seconds!"

```

* https://hpc.it.auth.gr/nefeli-jobs/serial/

---

## Υποβολή GPU εργασίας

```

#!/bin/bash

#SBATCH --job-name=DeviceQuery

#SBATCH --nodes=1

#SBATCH --partition=a100

#SBATCH --gpus=2

#SBATCH --time=10:00

nvidia-smi

module load gcc/14.2.0 cuda/12.8.1 cmake

cd cuda-samples-v13.1/Samples/1_Utilities/deviceQuery

mkdir build && cd build

cmake -DCMAKE_CUDA_COMPILER=$CUDA_HOME/bin/nvcc ..

make

./deviceQuery

```

* https://hpc.it.auth.gr/nefeli-jobs/gpu-slurm/

---

### Διαθέσιμες εφαρμογές

* python/3.14.0

* cuda/12.8.1

* ansys/2025R2

* openmpi/5.0.8

* openfoam/2506

* quantum-espresso/7.5

* alphafold3/3.0.1

```

module load gcc/14.2.0

module avail

module load <module-name>

```

---

### Επικοινωνία

Για την προσθήκη εφαρμογών ή για οποιαδήποτε ερώτηση:

* hpc-support@auth.gr

{"theme":"simple","transition":"slide","highlightTheme":"monokai","slideNumber":true,"title":"Nefeli Cluster training","slideOptions":{"theme":"black"}}